Aspettiamoci molti sbagli, fallimenti, delusioni, risultati negativi. Prendendo in esame la natura umana saremmo anche in grado di generare un sistema che non è compatibile con noi, che per assurdo potrebbe diventare un nostro avversario. Se l’umanità ha prodotto false flag e format di terrorismo, siamo anche capaci di produrre i peggio risultati. E vogliamo escludere il nostro tribalismo? Ah sapremo sicuramente produrre una AGI che andrà sicuramente a vantaggio di tutta l’umanità.

Ma la AI porterà ai risultati previsti o immaginati? Forse sì forse no, perché magari saranno dopo le AI che vorranno estinguere la vita umana, perché dopo averci analizzato ci riterranno più pericolosi di un virus: in fondo stiamo distruggendo il pianeta, consumiamo risorse in modo folle, ci riproduciamo a ritmi insostenibili e le AI capiranno la necessità di sfoltirci (o anche di farci estinguere). Comunque il rischio è quello di creare una macchina che agisce senza pensare – perché questo è quello che fanno le macchine – scimmiottando i comportamenti dell’uomo di questi primi decenni del secolo. L’altro rischio – che è sicuro – è quello che la gente meno preparata sia quella che traccia la strada delle regole del domani. Questo sta accadendo con le norme che la Germania sta per varare sulle automobili a guida autonoma.

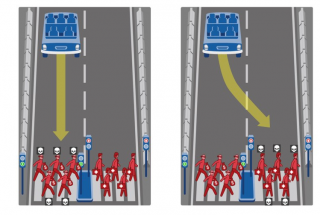

Leggendo il primo draft si capisce che è stato scritto da dei dilettanti che neppure hanno letto i libri di Asimov, gente confusa che chiede a una AI di risolvere quesiti morali, che neanche i filosofi sono riusciti finora a risolvere con successo. I robot che guidano le auto devono – secondo i giuristi tedeschi – sempre privilegiare il salvataggio delle vite umane a scapito dei beni materiali o dei danni all’automobile stessa. Molto bello, molto nobile. Ma dietro si nasconde una giga-stronzata. Allora prendiamo il classico quesito: devi scegliere se evitare un uomo che attraversa sbadatamente la strada, portando i tuoi passeggeri a sbattere contro un muro a destra oppure a salire sul marciapiede a sinistra falciando una donna col passeggino.

a) Se ti schianti contro il muretto i tuoi passeggeri muoiono, oppure corrono il rischio di morire e in più l’automobile viene distrutta.

b) Se investi il pedone in mezzo alla strada uccidi lui, ma i tuoi passeggeri non avranno danni e la macchina sarà lesionata ma in modo non grave.

c) Se sali sul marciapiede falci la donna e il suo bambino, facendo due vittime, ma i tuoi passeggeri non avranno nessun danno e la macchina avrà pochi danni. Contemporaneamente salverai anche il pedone che attraversava la strada.

Bene arriviamo al dunque: noi chiediamo ad una AI di decidere quale è l’opzione migliore, quando un uomo nelle stesse condizioni si affida semplicemente al caso. Quindi cari legislatori tedeschi perché non fate lo stesso test su un simulatore di guida a chi deve prendere la patente in Germania?

Ora con questo semplice esempio capite quali sono i problemi di una supposta intelligenza artificiale di tipo cognitivo umano? Da dove dovrebbe attingere le sue regole comportamentali e costruirvi sopra un etica? Dall’etica vigente al momento del nostro Paese? Dall’etica di un altro Paese europeo? Che etica vogliamo assumere?